Künstliche Intelligenz hält in rasantem Tempo Einzug in moderne Kommunikations- und Kollaborationstools. Daher dürfen Sicherheitsrisiken nicht unterschätzt werden. Wichtig ist es, jederzeit die Kontrolle und Hoheit über die eigenen Daten zu behalten, sagt Andrea Wörrlein von VNC.

Die Vorteile der generativen KI (GenAI) sind beeindruckend. Sie kann die Arbeit im Büro auf unterschiedliche Weisen beeinflussen – und sie im Idealfall schneller, einfacher und produktiver machen. Chatbots oder die KI-Assistenten für die Kommunikation und Kollaboration in entsprechenden Applikationen sind plakative Beispiele dafür. Kein Wunder also, dass GenAI immer weiter in unseren Arbeitsalltag vordringt. Durch die mit ihr erzielbaren Effizienz- und Produktivitätsvorteile steigt der Anwendungsdruck. Was jedoch nicht übersehen werden darf, sind die damit verbundenen Risiken, insbesondere im Hinblick auf Datenschutz und Datensouveränität.

Die latenten Gefahren

Das Herzstück generativer KI-Anwendungen sind die sogenannten Large Language Models (LLMs). Die Krux dabei ist, dass LLMs in der Regel exklusiv an die Plattform des jeweiligen Anbieters gebunden sind. ChatGPT ist beispielsweise ausschließlich auf der Azure-Plattform von Microsoft verfügbar. Es droht also immer die latente Gefahr eines Vendor-lock-in mit den damit zwangsläufig verbundenen Abhängigkeiten und Sicherheitsrisiken für die eigenen Daten. Das hinterlässt häufig ein mulmiges Gefühl, denn immerhin kann es dabei um unternehmenskritische Informationen, sensible personenbezogene Daten oder gar das geistige Eigentum eines Unternehmens gehen – von der Einhaltung verbindlicher DSGVO- oder Compliance-Vorgaben ganz zu schweigen. Hier setzt Confidential Computing an.

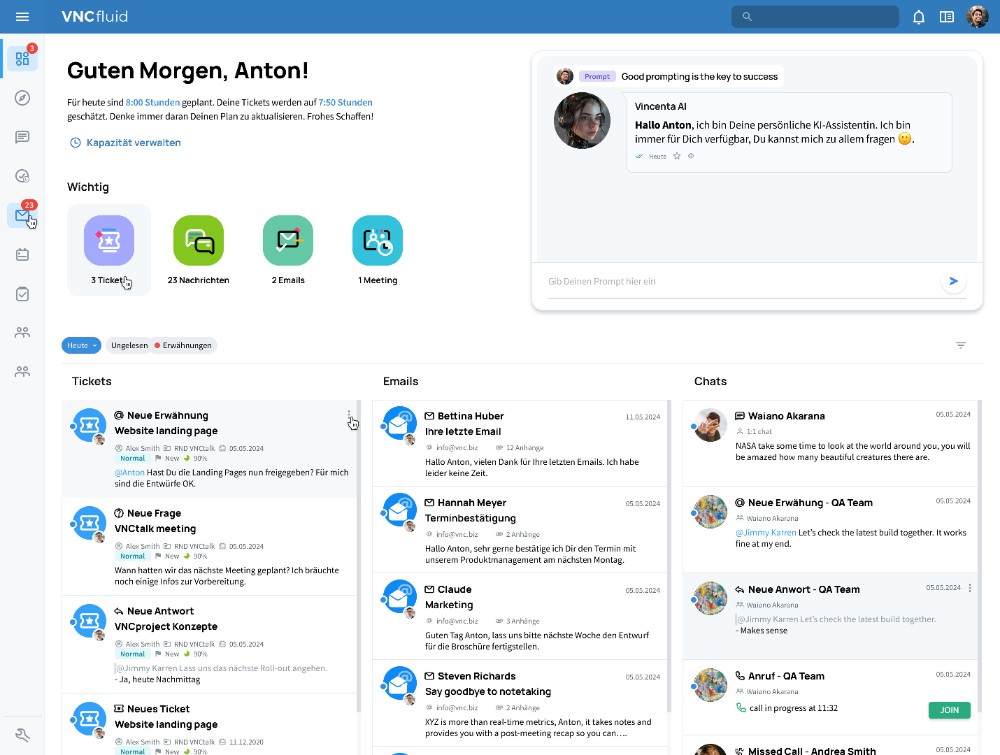

Über das intelligente Dashboard sind alle wichtigen Aufgaben und Prozesse übersichtlich in direktem Zugriff. Abbildung: VNC

Lokale KI-Modelle

Ideal wäre es, die LLMs lokal im eigenen Rechenzentrum nutzen zu können. Durch entsprechende Toolkits (natürlich Open Source) ist es möglich, abgespeckte Modelle über entsprechende Applikationen direkt auf dem lokalen PC oder dem mobilen Endgerät auszuführen. Eine hochintegrierte modulare Plattform für Kommunikation und Kollaboration kann diese LLMs dann zentral für alle Anwendungen bereitstellen, etwa für Chatprogramme oder Projektmanagement. Das hat den Vorteil, dass das weitere Training und Feintuning der KI-Modelle intern und mit Bezug auf die eigene Wissensbasis erfolgen kann.

Diese plattforminternen Funktionen müssen natürlich mit ergänzenden Maßnahmen wie Auditierbarkeit, automatisierten Analysen und Sicherheitschecks sowie einem ausgefeilten Zugriffs- und Berechtigungsmanagement gekoppelt werden, um die Integration generativer KI in die Arbeitswelt auf allen Stufen unterhalb der eigentlichen Applikationsebene sicherheitskompatibel zu gestalten.

Andrea Wörrlein, Geschäftsführerin, |